고정 헤더 영역

상세 컨텐츠

본문

금융시장과 강화학습

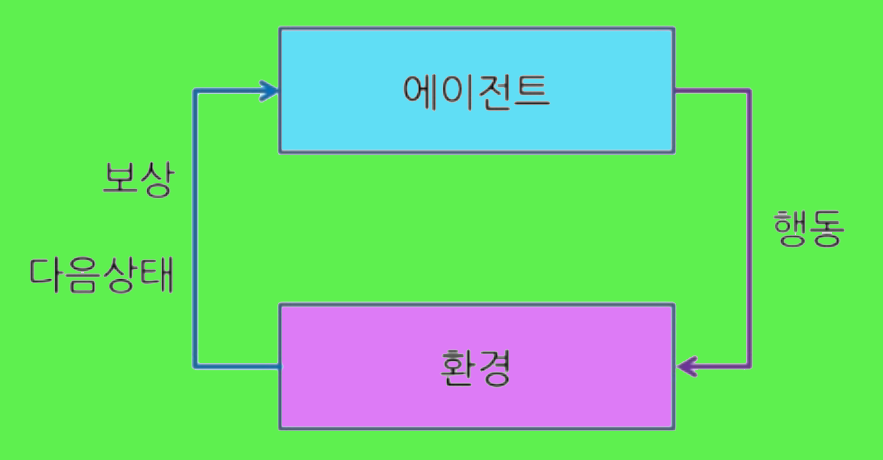

화학습은 환경으로부터의 피드백을 기반으로 최적의 결정을 학습하는 방법으로, 금융에서는 특히 복잡한 의사결정 과정에 유용하다. 예기에는 몇 가지 시나리와 구현하는 방법이 있는데, 이는 다음과 같다.

Ⅰ. 알고리즘 트레이딩에서의 강화학습 구현

■ 구현 단계:

1. 데이터 수집 및 전처리: 과거 및 실시간 시장 데이터를 수집한다. 이 데이터에는 주식 가격, 지수, 거래량, 매크로 경제 지표 등이 포함된다. 데이터 가공 단계에서 노이즈를 제거하고 필요한 특성으로 변환하여 학습에 적합하게 만든다.

2. 환경 설정: 강화학습에서의 '환경'은 트레이더가 상호작용하는 시장을 시뮬레이션하는 것을 말한다. 이 환경은 에이전트의 행동에 따라 다음 상태를 반환하고, 해당 행동의 결과로서 보상을 계산한다.

3. 에이전트 설계: 에이전트는 신경망과 같은 모델을 사용하여 행동을 결정한다. 에이전트의 목표는 보상을 최대화하는 전략을 학습하는 것이다. 즉, 보상 비율이 높은 방향으로 학습하는 것이다.

4. 학습과정: 에이전트는 시장 환경 내에서 실험을 통해 다양한 행동을 취하고, 그 결과로 보상을 받아 정책을 점차 개선한다. 이 과정은 특정 기준이 충족되거나, 성능이 일정 수준에 도달할 때까지 반복된다.

5. 백테스팅: 학습된 전략을 과거 데이터에 적용하여 성능을 검증한다. 이 단계는 실제 거래 전에 리스크를 평가하는 데 중요하다.

Ⅱ. 포트폴리오 최적화에서의 강화학습 구현

■ 구현 단계:

1. 상태 공간 설계: 포트폴리오의 현재 구성과 시장 상태를 포함하는 상태 공간을 정의한다. 이는 자산의 비중, 가격, 시장 변동성 등 다양한 요소가 포함된다.

2. 행동 정의: 포트폴리오 재조정을 위한 행동으로는 각 자산의 매수, 매도 또는 보유가 있다. 행동은 비중의 조절을 의미할 수도 있다.

3. 보상 함수: 포트폴리오의 기대 수익과 리스크를 조합한 보상 함수를 설계한다. 이는 종종 샤프 비율 같은 리스크 조정 수익률을 사용하여 계산된다.

4. 학습 알고리즘: Q-Learning, Deep Q-Networks (DQN), 또는 Proximal Policy Optimization (PPO)와 같은 강화학습 알고리즘을 적용하여 최적의 행동 정책을 찾는다.

5. 시뮬레이션 및 평가: 학습된 전략을 시뮬레이션을 통해 평가하고, 실제 시장 데이터를 사용하여 성능을 검증한다.

Ⅲ.신용 스코어링과 대출 결정에서의 강화학습 구현

■ 구현 단계:

1. 상태 공간: 대출 신청자의 재정적 상태, 신용 기록, 고용 상태 등이 포함된다.

2. 행동: 대출 승인, 거절, 대출 조건 설정 등의 결정을 행동으로 정의한다.

3. 보상 함수: 대출 이후의 상환 성공률, 부도율, 이자 수익 등을 기반으로 보상을 설계한다.

4. 학습 과정: 에이전트는 데이터에서 학습하여 최적의 대출 결정 정책을 개발한다.

Ⅳ. 가격 책정 및 부도 위험 관리에서의 강화학습 구현

■ 구현 단계:

1. 상태: 시장 상태, 경쟁사 가격, 고객 데이터 등이 포함된다.

2. 행동: 상품의 가격 책정 또는 조건 변경 등을 적용한다.

3. 보상 함수: 판매량, 수익성, 고객 만족도를 포함한 다양한 지표를 통해 보상을 계산한다.

4. 학습: 학습 알고리즘을 적용하여 가격 책정 전략을 최적화한다.

이러한 방식으로 강화학습은 금융 부문에서 복잡한 의사결정을 지원하고, 실시간으로 변화하는 시장 환경에 효과적으로 대응할 수 있는 전략을 개발하는 데 기여할 수 있다. 또한 금융 분야의 다양한 의사결정 과정에서 효율성과 성과를 개선하는 데 도움을 줄 수 있다.

'강화학습' 카테고리의 다른 글

| '데이터 전처리'가 필요한 이유 (0) | 2024.05.11 |

|---|---|

| 인공지능에서 자기참조 적용 (0) | 2024.04.30 |

| 괴델의 '자기참조'와 인공지능 (0) | 2024.04.16 |

| 강화학습 적용 - 로봇공학 (0) | 2024.04.04 |

| 일상생활에서 접할 수 있는 강화학습 – 1 (맞춤형 추천) (0) | 2024.04.03 |