강화학습이란?

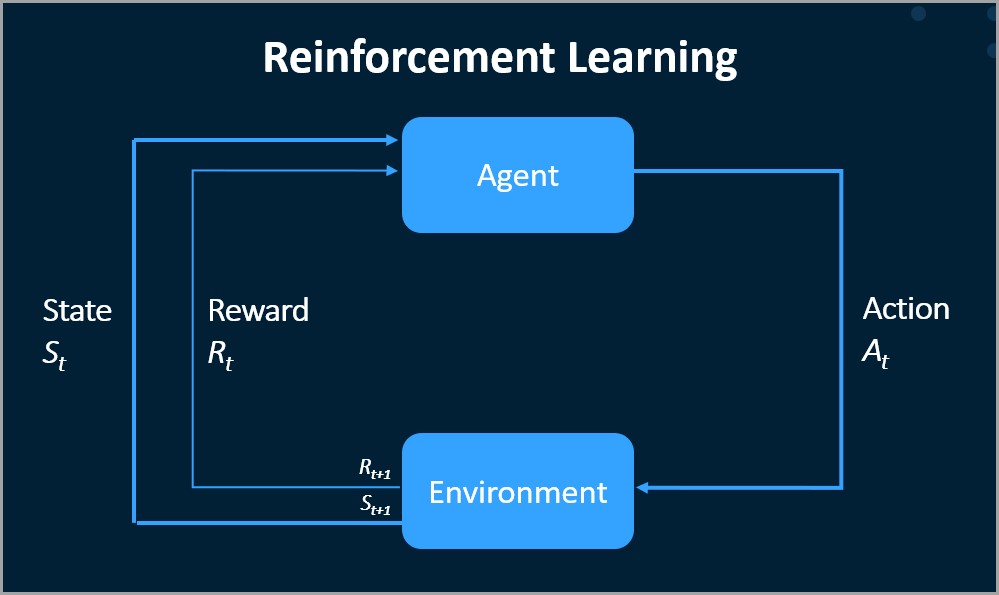

강화 학습(RL)은 에이전트가 목표 달성을 위해 환경에서 작업을 수행하여 결정을 내리는 방법을 학습하는 일종의 기계 학습이다. 학습 프로세스는 보상과 처벌의 개념에 의해 주도된다. 에이전트를 목표에 더 가깝게 이동시키는 행동에는 보상이 주어지고 멀어지는 행동에는 처벌이 적용된다. 이 설정은 에이전트가 시간이 지남에 따라 누적 보상을 최대화하는 전략 또는 정책을 개발하도록 장려된다. 강화학습의 구성요소와 프로세스는 다음과 같다.

RL의 핵심 구성요소

1. 에이전트: 에이전트는 학습하고 결정을 내리는 개체입니다. 환경 상태를 관찰하고, 정책에 따라 행동을 결정하고, 보상을 통해 피드백을 받고, 그에 따라 정책을 업데이트한다.

2. 환경: 환경은 상호작용하는 에이전트 외부의 모든 것입니다. 에이전트에게 상태를 제시하고 에이전트의 작업을 수신하며 이러한 작업을 기반으로 새로운 상태로 전환하고 보상을 제공한다. 환경은 단순한 게임부터 복잡한 생태계까지 사실상 모든 것이 될 수 있다.

3. 상태(S): 상태는 에이전트가 자신을 발견하는 구체적이고 즉각적인 상황이다. 이는 특정 시점에 결정을 내리는 데 필요한 모든 관련 정보의 스냅샷이다. 가능한 모든 상태의 집합을 상태공간이라고 한다.

4. 액션(A): 액션은 에이전트가 내릴 수 있는 가능한 이동이나 결정의 집합이다. 작업 공간은 이산적(예: 왼쪽 또는 오른쪽)이거나 연속적(예: 다양한 스로틀 수준)일 수 있다.

5. 보상(R): 보상은 에이전트가 취한 마지막 조치를 평가하기 위해 환경에서 에이전트에게 즉시 제공되는 반환이다. 보상은 긍정적(행동 강화)일 수도 있고 부정적(행동 낙담)일 수도 있다.

RL의 주요 프로세스

1. 정책(π): 정책은 상태를 작업에 매핑하는 에이전트가 사용하는 전략이다. 이는 상태가 특정 행동에 매핑되는 결정론적일 수도 있고, 상태가 행동에 대한 확률 분포에 매핑되는 확률론적일 수도 있다.

2. 가치 함수(V): 이 함수는 특정 정책에 따라 에이전트가 해당 상태에서 누적될 것으로 예상할 수 있는 미래 보상을 고려하여 특정 상태에 있는 것이 얼마나 좋은지 추정한다. 이는 본질적으로 미래 보상에 대한 예측이다.

3. Q-함수(Q): Q-함수는 특정 상태에서 특정 행동을 취하는 것이 얼마나 좋은지 추정하고 다시 미래 보상을 고려하여 가치 함수를 확장한다. Q-값은 에이전트가 각 상태에서 각 작업의 잠재력을 평가하는 데 도움이 된다.

강화학습을 하는 방법에는 여거가지가 있는데, 대표적인 것은 다음과 같다

1. 모델 기반 RL: 이 접근 방식에서 에이전트는 환경 모델(상태 전환 및 보상 예측)을 구성하고 이 모델을 사용하여 결정을 내린다. 이는 효율적일 수 있지만 정확한 모델링이 필요하므로 많은 환경에서 복잡하거나 비실용적일 수 있다.

2. 모델 없는 RL: 여기서 에이전트는 환경을 모델링하려고 시도하지 않고 경험을 통해 직접 학습한다. 이 접근 방식은 보다 광범위하게 적용 가능하며 Q-학습 및 정책 그라데이션과 같은 방법을 포함한다.

3. 탐색 대 활용: RL의 중요한 측면은 탐색(보상을 발견하기 위해 새로운 작업 시도)과 활용(높은 보상을 제공하는 알려진 작업 사용) 간의 균형이다. 효과적인 학습에는 에이전트가 확률 ε으로 무작위로 탐색하고 확률 1-ε으로 가장 잘 알려진 작업을 활용하는 ε-탐욕과 같은 접근 방식을 사용하여 이 두 가지의 균형을 맞추는 전략이 필요하다.

4. 심층 강화 학습: RL과 딥 러닝을 결합하는 방법이다. 여기서 심층 신경망은 가치 함수, Q 함수 또는 정책을 근사화하는 데 사용된다. 이 접근 방식은 비디오 게임 및 로봇 공학과 같은 고차원 상태 공간이 있는 복잡한 환경에서 성공적이었다.

5. 시간적 차이(TD) 학습: 연속된 값 추정 간의 차이(또는 "시간적 차이")를 기반으로 값 추정을 업데이트하는 방법이다. 이를 통해 환경 모델 없이 원시 경험을 통해 직접 학습할 수 있다.

6. 몬테카를로 방법: 이 방법은 전체 경험 에피소드를 통해 직접 학습한다. 에피소드가 끝날 때까지 기다렸다가 실제 수익을 사용하여 가치 함수를 업데이트한다. 이는 덜 효율적일 수 있지만 TD 방법과 같은 부트스트래핑이 필요하지 않다.